Investigacion 1

HISTORIA DE LAS COMPUTADORAS

La Época Antigua

El Ábaco

El ábaco representa el artefacto más antiguo empleado para manipular datos. Se cree que alrededor del año 3000 BC, los babilonios empleaban el ábaco para realizar cómputos matemáticos rudimentarios.

Los Pioneros

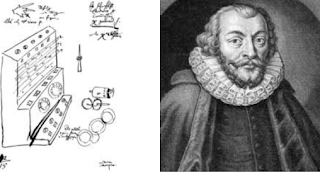

En 1617 – John Napier John Napier, un matemático Escocés, inventó los Huesos o Bastoncillos de Napier. Este artefacto permitía multiplicar grandes números mediante la manipulación de estos bastoncillos.

Rosch, W. L. (1997). Hardware Bible, Premier Edition. Indianapolis, IN: Sams Publishing

La Época Antigua

El Ábaco

El ábaco representa el artefacto más antiguo empleado para manipular datos. Se cree que alrededor del año 3000 BC, los babilonios empleaban el ábaco para realizar cómputos matemáticos rudimentarios.

Los Pioneros

En 1617 – John Napier John Napier, un matemático Escocés, inventó los Huesos o Bastoncillos de Napier. Este artefacto permitía multiplicar grandes números mediante la manipulación de estos bastoncillos.

En el año de 1623 – Wilhelm Schickard

Wilhelm Schickard fue el primer matemático en intentar desarrollar una

calculadora. Nativo de Alemania, aproximadamente para el año 1623, éste matemático

construyó un mecanismo que podía sumar, restar, multiplicar y dividir. Su plan era

enviar a su amigo, Johannes Keple, una copia de su nueva invención, pero un fuego

destruyó las partes antes que fueran ensambladas. El prototipo nunca fue encontrado,

pero un esquema rudimentario de esta máquina sobrevivió. Para la década de los 1970,

fue construido un modelo de este tipo de computador matemático.

(Capron, H. L. (1990). Computers: Tools for an Information Age. (2nd ed.). California:

The Benjamin/Cummings Publishing Company, Inc.)

Herman Hollerith será uno de los primeros en sacar partido tanto de el sistema de tarjetas

perforadas, como del álgebra de Boole y de los sistemas eléctricos. Sobre estos tres elementos

desarrolló una máquina tabuladora para realizar el censo de

1890 en los Estados Unidos, consiguiendo reducir un tiempo

estimado de diez años a dos años y medio.

Se trataba de una prensa manual que detectaba los

orificios en las tarjetas perforadas. Tenía un alambre que

pasaba a través de los huecos hasta una copa de mercurio

debajo de la tarjeta, cerrando de este modo el circuito

eléctrico. Este proceso disparaba unos contadores mecánicos

y ordenaba los recipientes de las tarjetas, tabulando así en

forma apropiada la información.

Tan útil y novedoso resultó ser su sistema que en 1896

fundaba la Tabulating Machine Company para comercializar

su creación. El mercado que abría esta clase de invenciones

hizo que no tardaran en aparecer competidores a Hollerith.

Uno de ellos, James Powers desarrolló el sistema encargado

del censo de 1910 y creó Power's Tabulating Machine

Company, que se convertía así en la competencia de la

empresa de Hollerith. Ésta última, se fusionó con otras dos en

1924 dando lugar a la International Business Machine

Corporation (IBM), aunque Hollerith ya se había retirado tres

años antes .

Durante los años posteriores no aparecieron

dispositivos dignos de mención, aunque muchos científicos ya

trabajaban en los que se convertirían en los protagonistas de la Primera Generación de

Computadores.

PRIMERA GENERACIÓN: LAS VÁLVULAS DE

VACÍO (1946-1957)

Tecnología básica

En 1904, Fleming patenta la válvula de vacío diodo, con idea de utilizarla

para mejorar las comunicaciones de radio. En 1906, Forest añade un tercer

electrodo al flujo de corriente de control del diodo de Fleming, para crear la

válvula de vacío de tres electrodos.

Los computadores mecánicos tenían grandes dificultades para conseguir

aumentar su velocidad de cálculo, debido a la inercia de los elementos móviles.

Por ello el uso de válvulas de vacío supuso un gran paso adelante en el

desarrollo de los computadores, tanto en velocidad como en fiabilidad, y dio

lugar a lo que se conoce como Primera Generación de computadores.

Hutchinson, S. E., & Sawyer, S. C. (1996). Computers and Information Systems. Chicago: Richard D. Irwin, a Times Mirror Higher Education Group, In., Company.

Hutchinson, S. E., & Sawyer, S. C. (1996). Computers and Information Systems. Chicago: Richard D. Irwin, a Times Mirror Higher Education Group, In., Company.

LA PRIMERA GENERACIÓN DE COMPUTADORES (1939- 1958)

Los avances que conforman lo que más tarde será conocido como Primera Generación de

computadores serán llevados a cabo por diferentes personajes simultánea e interrelacionada, de

manera que resulta imposible estudiar sus trabajos sin relacionarlos al mismo tiempo con su

aplicación a las ya míticas computadoras que crearon o en cuyo desarrollo participaron más

activamente. Así, Konrad Zuse va inexorablemente ligado a sus ENIAC, EDVAC, BINAC y UNIVAC, que

conformarán el final de la generación. Sin embargo, una figura destaca sobre todas ellas: John Louis

Von Neumann, considerado el padre de las computadoras modernas por sus grandes aportaciones

que comenzamos a detallar en primer lugar.

John Von Neumann: el padre de las computadoras modernas

John Von Neumann es considerado hoy como el

padre de las computadoras modernas. Nacido en

Budapest en 1903 y destacó muy pronto por su gran

memoria. Considerado desde pequeño como un genio

sus aptitudes para las matemáticas estaban muy claras

aunque su padre le influenció para estudiar física. No

se separó sin embargo de las matemáticas y consiguió

su doctorado por la universidad de Budapest con una

tesis sobre la axiomatización de la teoría de conjuntos

que fue publicada cuando Neumann tenía tan sólo 20

años.

En 1930, Von Neumann contaba ya con un gran

prestigio por sus trabajos en el ámbito de la física

cuántica y matemáticas.

Ese mismo año, fue invitado a conocer la Universidad de Princeton. Las capacidades de

investigación que los Estados Unidos ofrecían le impulsaron a nacionalizarse americano. De 1936 a

1938 supervisó una disertación doctoral de Alan Turing, del que hablaremos más adelante, en el

Instituto de Estudios Avanzados (IAS), dónde había entrado como profesor en 1933

Norton, P. (1997). Peter Norton Toda la PC (5th ed.). México: Prentice Hall Hispanoamericano, S. A.

Norton, P. (1997). Peter Norton Toda la PC (5th ed.). México: Prentice Hall Hispanoamericano, S. A.

El primer contacto de Neumann con los computadores vino de la mano de Howard Aiken y

su trabajo con el Harvard Mark I en 1944. Los esfuerzos de cálculo que sus trabajos requerían

hicieron que pensara en el uso de dispositivos mecánicos para su cómputo. En la primavera de 1955

escribiría las bases de todo su trabajo en el “First Draft of a Report on the EDVAC” (Primer boceto

de un informe sobre el EDVAC), un escrito dirigido a John Mauchly y J. Presper Eckert,

diseñadores del computador electrónico EDVAC en la Universidad de Pennsylvania.

El informe organizaba un sistema computador en cuatro partes principales: la Unidad

Central Aritmética (UA), la Unidad de Control (UC), la Memoria (M) y los dispositivos de

Entrada/Salida (E/S). La UA debía ser capaz de realizar las cuatro operaciones aritméticas

elementales y quizás otras como raíces, logaritmos o funciones trigonométricas y sus inversas. La

UC debería controlar la correcta ejecución secuencial de las operaciones y hacer que las unidades

individuales trabajen juntas para llevar a cabo la tarea específica programada en el sistema. La

memoria debería almacenar los datos numéricos (valores de inicialización, constantes, tablas de

funciones prefijadas) e instrucciones codificadas numéricamente. Los dispositivos E/S deberían

comunicar al usuario con el interfaz del computador.

Von Neumann se preocupó más

de presentar una descripción lógica del

programa almacenado que de un

diseño real de las piezas del

computador. Le preocupaba la

estructura general del computador, las

partes abstractas que lo componen, sus

funciones y como interactúan para

procesar la información. Los

materiales específicos o el diseño de la

implementación de las partes no fueron objeto de su análisis. Cualquier tecnología que se adecuara

a las especificaciones funcionales podría ser usada sin problemas en sus resultados.

Neumann trabajaría en su propio computador, el IAS computer, finalizado en 1952. EL IASC fue

el primero en mezclar programas y datos en una misma memoria, compuesta de tubos de vacío. Así,

Von Neumann mostró como la combinación de instrucciones y datos podría ser usada para

implementar bucles, modificando instrucciones base cuando una iteración era completada. Era un

computador asincrónico que realizaba una operación tras acabar la anterior. EL IASC sería el

modelo a copiar por muchos modelos desarrollados en los años posteriores en diferentes países y

universidades conocidos como Máquinas IAS.Rosch, W. L. (1997). Hardware Bible, Premier Edition. Indianapolis, IN: Sams Publishing

El ingeniero alemán Konrad Zuse (1910-1995) nació en Berlín y se graduó como ingeniero

civil por el Technische Hochschule Berlin-Charlottenburg (actualmente Universidad Tecnológica

de Berlín). Durante sus estudios de ingeniería, Zuse tenía que

realizar muchos cálculos rutinarios a mano, lo que encontró

extremadamente aburrido. Esta experiencia lo llevó a soñar con una

máquina que pudiera hacer cálculos20

.

Como el mismo relataba en una de sus conferencias, comenzó sus trabajos en 1934 sin ni siquiera haber oído hablar de

Babagge. Las máquinas de la época eran principalmente

calculadoras electromecánicas basadas en el sistema decimal y

destinadas al uso comercial, por lo que se vio obligado como otros

muchos ingenieros y matemáticos de la época a desarrollar sus

propios computadores.

Zuse lo hizo desde dos puntos de vista:

• Lógico y matemático: programa de control, uso del sistema binario, aritmética de punto

flotante.

• Diseño: Necesitaba un computador que permitiese cálculos matemáticos completamente

automáticos, una memoria de alta capacidad y módulos o relés que operaran bajo el

principio de “sí” o “no”.

Estos conceptos eran completamente novedosos en la época en los que Zuse los concibió.

Fue uno de los primeros en darse cuenta de la importancia de un simple bit, y de que cualquier pieza

de información podía ser representada con un número de ellos.

Esta relación entre la lógica matemática

y la tecnología no estaba del todo clara por

entonces. El puente de unión entre ambas

habría de ser un dispositivo que trabajase bajo

el principio de todo o nada, sobre el que se

pudiera aplicar lo que ahora se conoce como

álgebra de Boole. Los únicos elementos con

estas capacidades eran los relés (http://es.wikipedia.org/wiki/Konrad_Zuse "Computer Design - Past, Present, Future", Conferencia a cargo del Profesor Konrad Zuse, en Lund (Suecia), 2 de

Octubre de 1987. Transcripción en http://ei.cs.vt.edu/~history/Zuse.html.)

El Z1 en el apartamento de los padres de Zuse. 1936

Konrad Zuse

electromecánicos. Sin embargo Zuse se vio obligado a buscar dispositivos equivalentes de menor

tamaño y coste, como serían plaquitas de metal y pins, aunque la fiabilidad era claramente inferior.

Con este tipo de relés puramente mecánicos fue capaz de organizar una memoria binaria, con la

capacidad suficiente y un tamaño bastante reducido.

El prototipo diseñado finalmente fue la Z1 (1938), que puede considerarse como la primera

computadora binaria de la historia, aunque nunca llegó a funcionar correctamente. Parecía claro que

los relés electromecánicos eran la mejor opción para

mejorarla , pero antes de incluirlos crearía el Z2

(1940), haciendo uso de la memoria del Z1 y un

lector de tarjetas perforadas.

El Z2 contaba con 200

relés y capacidad de operar con 16 bits. El Z2 fue

más funcional, y además dotó a Zuse de la

experiencia necesaria para que un año más tarde

fabricara el Z3, definida por él mismo como “la

primera computadora completamente funcional del mundo”, esta vez sí, usando relés

electromecánicos.

Con una longitud de palabra de 22 bits (1 para el signo, 7 para la exponencial y 14 para la

mantisa), 2400 relés (1800 de ellos para la memoria) el Z3 era capaz de sumar, restar, multiplicar,

dividir y hallar la raíz cuadrada entre otras funciones.

No satisfecho con todo el trabajo realizado,

Zuse decidió mejorar ciertos aspectos del Z3 y

aumentar la capacidad de la memoria a 1,024

palabras, con varios lectores y perforadores de

tarjetas así como dispositivos que permitieran una

programación flexible (traducción de direcciones y

selección condicional). Tomaría el nombre de Z4. La

construcción y desarrollo del Z4 fue bastante épica:

sobrevivió diversos bombardeos y hubo que

transportarlo constantemente.

El Computador Atanasoff-Berry o ABC empezó a ser

concebido por el profesor de física John Vincent Atanasoff

(1903-1995) en 1933, formulando la idea de usar el sistema de

números binarios para su funcionamiento. Al buscar un

ayudante para cumplir con su innovativo propósito, un colega

le recomendó a un joven brillante, recién graduado en

ingeniería mecánica de nombre Clifford Berry.

Fue la primera computadora completamente electrónica

de la historia y su construcción se llevó a cabo en la

universidad de Iowa durante dos años, siendo finalizada en

1939. La máquina pesaba más de 320 kg. Contenía

aproximadamente 1.6 km de cable, 280 tubos de vacío y

ocupaba como una mesa de despacho.

Estaba diseñada para solucionar sistemas de ecuaciones

lineales con 29 incógnitas. Este tipo de problema era muy

típico en la física e ingeniería de aquella época. El sistema

era alimentado con dos ecuaciones lineales con 29

incógnitas y una constante, y eliminaba una de las variables.

El proceso se repetía de nuevo para eliminar otra variable

hasta llegar a una solución. El sistema tenía un error cada

100.000 cálculos, lo que en la práctica impedía asegurar que

los resultados fuesen correctos. Añadir un bit de paridad a

cada número podría haber solucionado estos problemas

fácilmente, pero el desarrollo del ABC quedó interrumpido

cuando Atanasoff abandonó la universidad para colaborar

con el ejército durante la Segunda Guerra Mundial.

Desde el punto de vista arquitectónico, el ABC contaba

con múltiples entradas de control constituidas por una mezcla de transmisores electromecánicos y

tubos de vacío electrónicos.

Bryn, P. (1995). Que Diccionario para Usuarios de Computadoras. México: PrenticeHall Hispanoamericano, S. A.

Bryn, P. (1995). Que Diccionario para Usuarios de Computadoras. México: PrenticeHall Hispanoamericano, S. A.

Para la representación numérica hacía uso de un bit de signo y

cincuenta de mantisa, lo que lo dotaba de una precisión extraordinaria de quince decimales.

Los elementos que constituían la memoria principal eran condensadores y fueron elegidos por que ofrecían mejor relación de coste por bit. Se trataba de una memoria regenerativa, que

necesitaba de un tiempo de refresco para recordar su estado, similar a las memorias RAM actuales.

En total había capacidad para 3264 bits organizados en dos bancos de 32 palabras.

Por otra parte, el ABC hacía uso de

aritmética paralela, pudiéndose considerar

como el primer computador vectorial

conocido. Cada elemento era una palabra

de cincuenta bits que se procesaba

secuencialmente. La operación básica del

ABC era entonces una multiplicación

paralela. En cada ciclo de reloj de un

segundo la computadora podía realizar

treinta sumas o restas simultáneas. Éstas se

llevaban a cabo a través de sumadores y restadores electrónicos simples (ASMs-Add-Subtract

Mechanisms). La multiplicación se basaba en un algoritmo de suma por desplazamiento que

avanzaba por las filas de la matriz del sistema de ecuaciones sumando cada fila a la siguiente. Para

completar una operación se requerían dieciséis ciclos de un segundo cada uno. Teniendo en cuenta

que los vectores o matrices de entrada estaban compuestos por treinta palabras, la velocidad de

cómputo del ABC era de sesenta operaciones, treinta operaciones de suma mas otras treinta de

desplazamiento.

Al ABC se le añadieron conversores de decimal a binario y viceversa para facilitar la

comunicación hombre-máquina. Además, contaba con una memoria secundaria formada por un

grabador y un lector de tarjetas binarias electrónico muy avanzado que, gracias al diseño en

paralelo, era capaz de leer y escribir simultáneamente a una velocidad de transferencia de mil

ochocientos bits por segundo, lo que le hacía muy superior a los lectores mecánicos de la época.

Tras terminar la Segunda Guerra Mundial, Atanasoff continuó trabajando para el gobierno y

desarrolló sismógrafos y microbarómetros especializados en la detección de explosiones a larga

distancia. En 1952 fundó y dirigió la Ordenance Engineering Corporation.

En 1956 vendería su

compañía a la Aerojet General Corporation y se convertiría en el presidente de su división atlántica.

El ABC se convirtió en un simple recuerdo y no sería hasta 1954 cuando se escucharon rumores de

que algunas de sus ideas habían sido “tomadas prestadas”.

Resulta que John Mauchly, padre del computador ENIAC (1946) junto con J. Prespert

Eckert y que revisaremos más adelante, tuvo la oportunidad de conocer y revisar la tecnología

utilizada por Atanasoff en el ABC. En varias ocasiones discutieron sus aspectos sin que Mauchly mencionara su proyecto. Cuando en 1942 Atanasoff abandonaba la universidad de Iowa para

colaborar con la marina estadounidense, dejó encargada la realización de la solicitud de patente,

pero el documento nunca fue rellenado. Tal olvido generó una dura batalla legal de seis años

finalmente resuelta en 1973 y que otorgaba la patente de la ENIAC a Atanasoff considerando que

"Eckert y Mauchly no inventaron ellos solos el primer computador electrónico y digital

automático, si no que partieron desde uno del Dr. John Vincent Atanasoff".

Ampliaremos la información sobre ENIAC más adelante, cuando hablemos de los trabajos de

Mauchly y Eckert.

El ABC se desmontó y se perdió en los sótanos de la universidad de Iowa. En 1997 se

construyó una réplica con un coste de 350.000 dólares que corroboró el buen funcionamiento del

modelo original y que actualmente se expone en la universidad que le vio nacer.

Fahey, T. (1995). Diccionario de Internet. México: Prontice-Hall Hispanoamericana, S.A.

Fahey, T. (1995). Diccionario de Internet. México: Prontice-Hall Hispanoamericana, S.A.

Touring fue uno de los principales impulsores del

proyecto Colossus, un computador creado para descifrar los

mensajes encriptados por la máquina alemana Enigma

26

durante la Segunda Guerra Mundial. Ya desde 1932,

criptógrafos polacos venían descifrando las comunicaciones

militares alemanas creadas por el Enigma de manera regular.

A partir de 1938 utilizaron dispositivos electromecánicos

para esta tarea: los llamados bomba, predecesores de los

bombe ingleses creados poco después. Sin embargo, en 1939

el nivel de cifrado alemán fue incrementado haciendo que los

bomba perdieran toda su efectividad. Fue entonces cuando la

inteligencia polaca cedió todos sus avances al gobierno británico, que empezaría a trabajar de

inmediato en medios de decodificación más avanzados

LA SEGUNDA GENERACIÓN DE COMPUTADORES (1954-1962)

Durante la década de los 40, los dispositivos bi-estables más rápidos y fiables para la

construcción de los computadores más avanzados eran los tubos de vacío. Como se ha visto, su uso

fue aumentando llegando a extremos como los

17.500 tubos del ENIAC. Sin embargo, los

tubos de vacío dejaban mucho que desear:

operaban a altas temperaturas consumiendo

mucha energía (ENIAC utilizaba el

equivalente a diez casas) y de manera

demasiado lenta para lo que sería deseable.

Además, su vida útil era relativamente corta

por lo que los aparatos que los utilizaban requerían un mantenimiento constante que no salía barato.

En 1947 entraría en juego la compañía estadounidense Bells Laboratories. Desde 1925,

investigadores de la compañía habían trabajado en diferentes campos desarrollando la amplificación

y transmisión de señales o la célula fotovoltaica

Microsoft Press. (1995). Computer Dictionary: The Comprehensive Standard for

Business, School, library, and Home (2nd ed.). Washington: Microsoft Press.

Bajo estos principios, los transistores podían realizar perfectamente el mismo trabajo que

habían venido realizando los tubos de vacíos, pero con múltiples ventajas

45

:

• Menor tamaño

• Fabricación altamente automatizada

• Coste inferior en grandes cantidades

• Posibilidad de trabajo con voltajes pequeños sin necesidad de

“precalentamiento” (los tubos de vacío necesitaban de 10 a 60

segundos).

• Menor disipación de calor.

• Mayor rendimiento y duración

• Posibilidad de controlar grandes voltajes.

Gracias a la fiabilidad, rapidez y ahorro aportados por el transistor

la venta de computadores se convirtió en un verdadero negocio cuyo

mercado no tardarían en copar 8 grandes compañías, con IBM a la cabeza.

La gran ventaja que llevaba sobre todas las demás hizo que en el mundo

empresarial fueran conocidas como “IBM y los Siete Enanitos”

El concepto de programa almacenado significaba que las instrucciones que el computador

debía realizar se encontraban almacenadas en la memoria y podían ser reemplazadas por otras

instrucciones. La necesidad de simplificar al máximo la tarea de reprogramar una computadora fue

el origen de los lenguajes de alto nivel sofisticados que comenzaron a aparecer en esta época. Estos

lenguajes reemplazaban el código máquina binario por otro compuesto por palabras, frases,

ecuaciones matemáticas y lógicas que hacían mucho más fácil el trabajo del programador

FORTRAN

FORmula TRANslation fue desarrollado por programadores de IBM y publicado por

primera vez en 1957. Fue especialmente diseñado para permitir un traslado fácil de fórmulas

matemáticas a código.

FORTRAN fue el primer lenguaje de alto nivel y usaba el primer compilador de la historia.

Anteriormente los programadores debían trabajar en código ensamblador o directamente en código

máquina lo cuál era extremadamente costoso. Como FORTRAN era mucho más fácil de usar, los

programadores eran capaces de escribir programas a una velocidad cinco veces superior cuando la

eficiencia de la ejecución se reducía tan sólo un 20%, lo que permitía una mayor concentración en

el modo de resolver problemas que en el de codificarlos

Bullough, R. V., Sr., & Beatty, L. F. (1991). Classroom Applications of Microcomputers. (2nd ed.). New York: Macmillan Publishing Company.

Bullough, R. V., Sr., & Beatty, L. F. (1991). Classroom Applications of Microcomputers. (2nd ed.). New York: Macmillan Publishing Company.

aunque ha habido grandes avances durante los últimos años en fiabilidad, rapidez y

prestaciones de los PC, la tecnología usada no difiere en gran medida de la que venía siendo en los

años 80 y 90. El nivel de integración de los chips ha aumentado hasta contener millones de

componentes en su interior, para reflejar este crecimiento se propuso el término ULSI (Escala de

Integración Ultra Grande). Sin embargo, no se puede decir que haya un salto cualitativo entre la

VLSI y la ULSI, y en la mayoría de los textos técnicos se sigue usando el primer término, a no ser

que se desee enfatizar la complejidad del chip. Esto nos lleva a poder considerar los computadores

personales actuales como los miembros más recientes de la Cuarta Generación.

Los años siguientes al lanzamiento del Apple Mac vendrán

marcados por una apertura del mercado que dejará de estar controlado

por el IBM PC y sus clones. Intel continua a la cabeza del desarrollo de

procesadores y lanza en 1986 su i386, de 32bits a 16 Mhz facilitando la

implementación de sistemas con memoria virtual y la utilización de

memorias mayores. Aunque la adopción de un procesador de 32 bits

fue lenta debido a la readaptación que las placas base y los periféricos

tuvieron que sufrir, el i386 se conformó como el modelo a seguir por los procesadores de los años

posteriores y base de la arquitectura x86 en la que aún se basan la mayoría de PCs

En 1987 IBM introduce sus Personal System/2 (PS/2) en un intento de recapturar el mercado

con la introducción de una avanzada arquitectura propietaria.

Se llegaron a vender más de un millón en el primer año y

muchas de sus aportaciones como los puertos PS/2 o el sistema

VGA de video se convertirían en los estándares del mercado

por muchos años. Como había pasado con el PC, Tandy, Dell

y otras compañías anunciaron sus sistemas compatibles PS/2

un año más tarde .

Mientras, en el campo del software, Microsoft tuvo la idea de lanzar un GUI que permitiera

al usuario interactuar con la máquina mucho más facilmente, utilizar varias aplicaciones a la vez

etc. Por supuesto la idea nacía de los GUIs incorporados por el Xerox Star, el Lisa, el Macintosh... y

fue llevada ha cabo relativamente rápido: en 1985 se lanzaba Windows 1.0. Al principio, Windows

no estaba concebido como un Sistema Operativo como tal, sino que era una aplicación que se

ejecutaba sobre MS-DOS, aunque si que asumía muchas tareas propias de los OS. MS-DOS por su parte siguió siendo desarrollado logicamente. Comenzó a cobrar especial importancia a partir de

1990 coincidiendo con el lanzamiento de su versión 3.0 que era compatible con los procesadores de

32 bits que iban apareciendo en el mercado (como el Intel i486 que llegaba a alcanzar velocidades

de 33Mhz)

126

. Con las posteriores versiones Windows se irá haciendo con una cuota muy

importante de sistemas para dar el salto definitivo en 1995 con Windows 95, que rompió todas las

expectativas

127

. Paralelamente se desarrolló el sistema operativo Windows NT orientado a

estaciones de trabajo, servidores... Basados en el 95 y funcionando sobre MS-DOS saldrían a la

venta Windows 98 (1998) y Windows ME (2000). Basados en el NT lo harían Windows 2000 y

Windows XP (2001).

Daines, D. (1981). Las Bases de Datos en la Educación Básica. Barcelona: Editorial Gustavo Gill.

Daines, D. (1981). Las Bases de Datos en la Educación Básica. Barcelona: Editorial Gustavo Gill.

Entre tanto, Intel daba un paso más en 1993 con la introducción

del Pentium . En su interior contaba con más de 3 millones de

transistores y las primeras versiones alcanzaban los 60Mhz. El Pentium

sería desarrollado hasta 1997 aumentando su velocidad (hasta 255Mhz)

y posibilidades (tecnología MMX)

130

. Más tarde vendrían los Pentium

II, III, IV. El último de ellos alcanza velocidades de 3.8 Ghz y contiene

42 millones de transistores en su interior131

. El último paso en el campo

de procesadores para PC ha sido la adopción del tamaño de palabra de

64 bits (arquitectura x86_64) y tanto Intel como AMD

132

han presentado

sus respectivas propuestas: los Pentium IV más recientes y los AMD Athlon 64 entre otros.

Aunque Intel y Microsoft hayan sido los grandes dominadores del hardware y

del software de los últimos años, no hay que olvidar las diferentes alternativas

existentes. Apple, por ejemplo, ha seguido desarrollando sus Macintosh y en

2001 presentaba su sistema operativo Mac OS X que ha dado fama a los Mac

de ser equipos muy estables, además de incorporar las mayores innovaciones

y avances en cuanto a GUI se refiere.

Sistemas como GNU/Linux comienzan a ser ampliamente aceptados por

muchos usuarios y soportan un gran número de arquitecturas diferentes.

Dockterman, D. (1989). Great Teaching in the Computer Classroom. Cambridge, MA: Tom Snyder Productions.

Dockterman, D. (1989). Great Teaching in the Computer Classroom. Cambridge, MA: Tom Snyder Productions.

Comentarios

Publicar un comentario